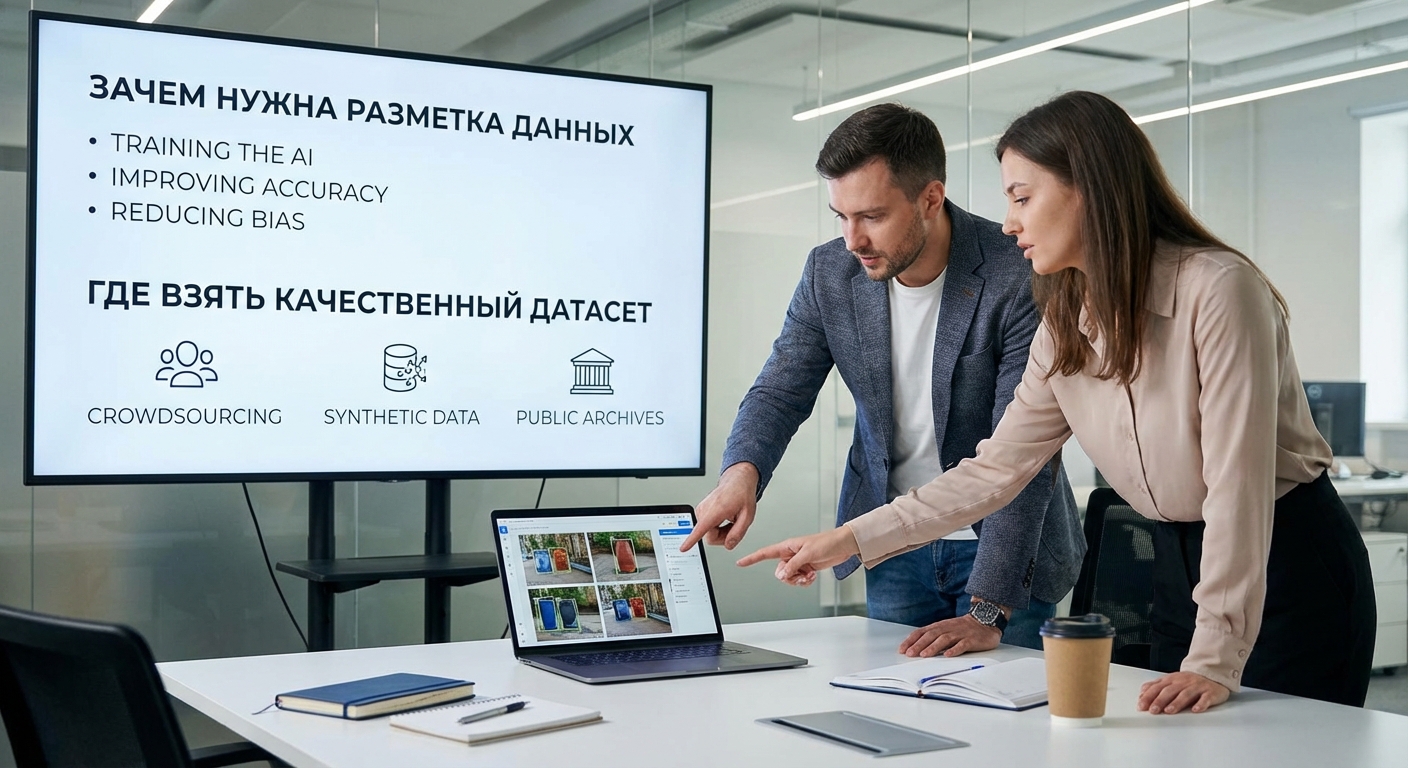

Зачем нужна разметка данных и где взять качественный датасет для обучения модели

Представьте, что вы решили построить самый быстрый в мире гоночный болид. Вы наняли лучших инженеров, использовали космические материалы и разработали идеальную аэродинамику. Машина готова, осталось залить топливо. И вот тут вы решаете сэкономить и вместо высокооктанового гоночного бензина заливаете в бак... воду из-под крана. Что произойдет? Ничего. Ваш суперкар за миллиард долларов не сдвинется с места. В лучшем случае. В худшем — двигатель выйдет из строя.

В мире искусственного интеллекта данные — это топливо. А размеченные данные — это то самое высокооктановое, идеально очищенное топливо, без которого ни одна нейросеть не научится делать ничего полезного.

Вы можете потратить миллионы на команду Data Science и аренду мощных GPU-серверов, но если вы будете «скармливать» своей модели необработанные, «грязные» или неподходящие данные, вы получите бесполезную цифровую игрушку, а не работающий бизнес-инструмент.

Эта статья — для тех, кто планирует ИИ-проект и хочет понять, откуда берется значительная часть его стоимости и сложности. Для директоров, которые слышат от разработчиков загадочные слова «датасет», «разметка», «аннотация» и хотят понимать, о чем идет речь.

Мы разберем:

- •Что такое разметка данных простыми словами и почему это 80% успеха любого ИИ-проекта.

- •«Мусор на входе — мусор на выходе»: как плохие данные убивают нейросети.

- •Где компании берут данные для обучения: от открытых источников до сбора «в полях».

- •Три способа получить размеченный датасет: инхаус, краудсорсинг и аутсорс.

- •Как контролировать качество разметки, чтобы не слить бюджет впустую.

- •Реальная стоимость данных: из чего складывается цена и на чем можно (а на чем нельзя) экономить.

Часть 1. Что такое разметка данных? Объясняем на котиках

Давайте представим простую задачу: мы хотим научить нейросеть отличать на фотографиях котиков от собачек. Для человека это элементарно, но компьютер видит любую картинку просто как набор пикселей — гигантскую таблицу с цифрами. Он не знает, что такое «уши», «хвост» или «усы». Чтобы его научить, мы должны ему это показать, буквально, как маленькому ребенку. Этот процесс и называется разметкой данных (Data Annotation).

Мы берем 10 000 фотографий и показываем их человеку-разметчику (аннотатору). Его задача — на каждой фотографии сделать пометку, например: «На этой картинке — кот», «А на этой — собака». Это самый простой вид разметки — классификация.

Теперь усложним задачу. Мы хотим, чтобы нейросеть не просто говорила, есть ли на фото кот, но и показывала, где именно он находится. Тогда разметчик будет выполнять более сложную работу: обводить каждого кота на фото прямоугольной рамкой (Bounding Box) или даже обводить его точный контур с точностью до пикселя (Полигональная сегментация). Если мы хотим научить нейросеть распознавать породы, разметчик будет ставить теги: «мейн-кун», «сфинкс», «британская».

Таким образом, разметка данных — это процесс превращения сырых, непонятных для машины данных (картинок, текстов, аудио) в структурированный, понятный ей обучающий материал с «правильными ответами». Нейросеть просматривает тысячи таких примеров, находит в них закономерности (например, что у котов определенная форма ушей и текстура шерсти) и постепенно «учится». Чем больше качественных, правильно размеченных примеров мы ей покажем, тем точнее она будет работать с новыми, незнакомыми данными. Этот же принцип работает для любых задач: от видеоаналитики на производстве, где разметчики обводят людей в касках, до анализа медицинских снимков, где врачи выделяют области, похожие на опухоли.

Часть 2. Принцип «Garbage In, Garbage Out»

«Мусор на входе — мусор на выходе» (GIGO) — главный закон мира данных. Качество вашей нейросети никогда не сможет превысить качество данных, на которых она обучалась. Даже самый совершенный алгоритм, обученный на некачественных примерах, будет выдавать ошибочные результаты.

Какие ошибки в данных могут «отравить» вашу модель?

1. Неправильная разметка (ошибки аннотаторов)

- •Пример: Разметчик случайно отметил собаку как кота. Или, обводя человека в каске, захватил в рамку кусок стены.

- •Последствия: Нейросеть получает неверный «урок» и начинает путаться. Если таких ошибок много, она научится распознавать «котособак» или «людей-стен». Точность модели падает.

2. Несбалансированный датасет

- •Пример: Вы хотите распознавать брак на конвейере. Вы показали модели 10 000 фото идеальных деталей и всего 10 фото бракованных.

- •Последствия: Модель решит, что брака почти не существует, и научится всегда говорить «все в порядке». Она будет отлично распознавать норму, но пропускать все дефекты, ради которых и создавалась.

3. Недостаточная вариативность

- •Пример: Вы обучаете систему распознавания лиц для СКУД, но все фотографии в датасете сделаны при идеальном дневном освещении, а люди смотрят прямо в камеру.

- •Последствия: Как только в офис придет человек в очках, в медицинской маске, в полумраке коридора или просто повернет голову в сторону — система его не узнает. Она не готова к реальным условиям.

4. Несоответствие данных реальной задаче (Domain Shift)

- •Пример: Вы взяли готовый датасет с фотографиями котиков из интернета (идеальные студийные фото), чтобы научить систему распознавать бездомных животных на уличных камерах (размытые, темные, снятые под углом).

- •Последствия: Модель, обученная на «идеальных» данных, будет совершенно беспомощна в реальном мире.

Вывод: Создание качественного датасета — это не менее важный и сложный процесс, чем написание кода и архитектура самой нейросети. Это фундамент. Если он кривой, весь ваш небоскреб ИИ рухнет.

Часть 3. Где взять данные для обучения?

Итак, для успешного проекта нужны данные — много и качественных. Где их брать?

1. Открытые (публичные) датасеты

Это наборы данных, собранные и размеченные исследователями, университетами или крупными компаниями (Google, Meta) и выложенные в открытый доступ.

- •Примеры: ImageNet (миллионы изображений для классификации), COCO (объекты в контексте), MNIST (рукописные цифры).

- •Плюсы:

- •Бесплатно.

- •Можно быстро скачать и начать экспериментировать.

- •Идеально для R&D, проверки гипотез, создания первого прототипа (MVP).

- •Минусы:

- •Обобщенность: Они не подходят для узкоспециализированных задач. Вы не найдете там датасет с дефектами сварных швов или снимками полок вашего конкретного магазина.

- •Проблема Domain Shift: Данные в них могут сильно отличаться от ваших реальных условий.

- •Лицензионные ограничения: Не все открытые датасеты можно использовать в коммерческих продуктах. Нужно внимательно читать лицензию.

2. Синтетические данные

Это данные, сгенерированные компьютером, а не собранные из реального мира.

- •Пример: Чтобы научить автопилот реагировать на пешеходов в тумане, не нужно ждать туманных дней и рисковать людьми. Можно нанять 3D-дизайнеров, которые создадут фотореалистичные сцены ДТП в любых погодных условиях.

- •Плюсы:

- •Дешевле и быстрее, чем сбор реальных данных, особенно для редких событий.

- •Полный контроль над параметрами (освещение, ракурсы).

- •Данные сразу «размечены».

- •Минусы:

- •Есть риск, что сгенерированные данные будут недостаточно реалистичными, и модель не сможет хорошо работать с реальным миром.

3. Парсинг и скрапинг

Сбор данных с общедоступных сайтов в интернете (например, с сайтов-агрегаторов, маркетплейсов).

- •Пример: Сбор фотографий и характеристик товаров для обучения системы рекомендаций в интернет-магазине.

- •Плюсы:

- •Можно собрать огромные объемы данных по нужной тематике.

- •Минусы:

- •Юридические риски: Сбор данных может нарушать условия использования сайта и законы об авторском праве.

- •«Шум»: Данные из интернета часто «грязные», с ошибками, дубликатами. Требуют серьезной очистки.

4. Данные клиента (проприетарные)

Это самый ценный и самый лучший источник — данные из реальных бизнес-процессов вашей компании.

- •Пример: Записи с камер видеонаблюдения, архив документов, история переписки с клиентами, данные из CRM и ERP.

- •Плюсы:

- •Идеально соответствуют вашей задаче и реальным условиям.

- •Это ваше уникальное конкурентное преимущество.

- •Минусы:

- •Их может быть недостаточно.

- •Они могут быть неструктурированными.

- •Их сбор и систематизация — это отдельный большой проект.

Часть 4. Кто будет размечать? Три модели работы

У вас есть сырые данные. Теперь их нужно превратить в обучающий датасет. Кто будет этим заниматься? Существует три основных подхода.

1. In-house (собственная команда)

Вы нанимаете в штат или выделяете своих сотрудников на роль разметчиков.

- •Когда подходит:

- •Для задач, требующих глубокой экспертизы (разметка медицинских снимков, юридических документов).

- •Когда данные сверхконфиденциальны и не могут покидать периметр компании.

- •Для небольших, пилотных проектов.

- •Плюсы:

- •Максимальный контроль над качеством и безопасностью.

- •Экспертиза остается внутри компании.

- •Минусы:

- •Дорого (ФОТ, налоги, менеджмент).

- •Медленно и плохо масштабируется.

- •Сложно быстро увеличить команду под большой проект.

2. Краудсорсинг

Вы используете онлайн-платформы (Яндекс.Толока, Amazon Mechanical Turk), где тысячи независимых исполнителей по всему миру готовы выполнять простые задания за небольшую плату.

- •Когда подходит:

- •Для больших объемов простых, не требующих экспертизы задач (классификация изображений, обводка простых объектов).

- •Плюсы:

- •Дешево.

- •Очень быстро.

- •Легко масштабируется до любых объемов.

- •Минусы:

- •Качество: Низкая вовлеченность исполнителей порождает много ошибок. Требуется сложная система контроля: перекрестная проверка (когда одно задание дают нескольким людям), тестовые задания, детальные инструкции.

- •Безопасность: Ваши данные видят тысячи анонимных пользователей. Не подходит для конфиденциальной информации.

- •Сложный менеджмент: Управление большим проектом на крауд-платформе — это полноценная работа.

3. Аутсорсинг (специализированные компании)

Вы нанимаете компанию, которая профессионально занимается разметкой данных. У них есть свои платформы, свои команды обученных разметчиков и менеджеры качества.

- •Когда подходит:

- •Для большинства коммерческих проектов, где требуется баланс скорости, качества и стоимости.

- •Плюсы:

- •Гарантия качества: Компании несут ответственность за результат, у них есть выстроенные процессы контроля (QA/QC).

- •Скорость и масштабируемость: Могут быстро собрать команду под ваш проект.

- •Безопасность: Работают по договору NDA, обеспечивая конфиденциальность данных.

- •Экономия на менеджменте: Вам не нужно управлять армией разметчиков, вы общаетесь с одним менеджером проекта.

- •Минусы:

- •Дороже, чем краудсорсинг.

Часть 5. Стоимость данных и контроль качества

Разметка данных — это не магия, а кропотливый ручной труд, который является одной из самых значительных статей расходов в R&D. Именно он часто составляет от 25% до 50% бюджета всего ИИ-проекта, и понимание факторов ценообразования критически важно для планирования.

Из чего складывается цена:

- •Тип разметки: Простая классификация — дешево. Сложная сегментация или разметка видео — дорого.

- •Требования к экспертизе: Разметить котиков может любой. Разметить юридические риски в договоре — только юрист.

- •Объем данных: Цена обычно считается за 1000 изображений, часов аудио или страниц текста.

- •Контроль качества: Многоуровневая проверка (когда работу одного разметчика проверяет другой, более опытный) увеличивает стоимость, но и повышает точность.

Как контролировать качество (даже на аутсорсе):

- •Четкое ТЗ: Создайте максимально подробную инструкцию для разметчиков с примерами правильной и неправильной разметки для всех пограничных случаев.

- •Тестовая партия: Прежде чем отдавать весь объем, закажите разметку небольшой тестовой партии (100-200 примеров). Проверьте ее лично, дайте обратную связь.

- •Метрика IoU (Intersection over Union): Для задач обводки объектов используется метрика, показывающая, насколько разметка двух людей (или человека и эталона) совпадает. Хорошим считается показатель > 0.8.

- •Перекрестная проверка (Consensus): Одно и то же задание дается нескольким разметчикам. Результат засчитывается, если их ответы совпали. Это золотой стандарт для повышения качества на крауд-платформах.

Заключение: Данные как стратегический актив

В наступившую эру искусственного интеллекта главным конкурентным преимуществом становится не сам алгоритм (многие из них находятся в открытом доступе), а уникальный, качественный, проприетарный датасет. Данные, которые вы собираете в ходе своих бизнес-процессов и кропотливо размечаете под специфику своей задачи, — это актив, который практически невозможно скопировать. Именно они становятся тем самым «секретным соусом», который делает вашу нейросеть умнее, точнее и эффективнее, чем у конкурентов, использующих общие, публичные наборы данных.

Поэтому подход к данным должен быть не тактическим, а стратегическим. Нельзя относиться к этому процессу как к второстепенной задаче, которую можно решить «как-нибудь потом» силами стажера. Тщательное планирование сбора, очистки, хранения и разметки данных — это первый и самый важный шаг на пути к успешному внедрению ИИ. Это не просто статья расходов в смете, а долгосрочная инвестиция, которая окупается сторицей в виде точности, надежности и реальной бизнес-ценности вашей будущей интеллектуальной системы.

Словарь терминов для директора

- •Датасет (Dataset): Структурированный набор данных (изображений, текстов, аудиофайлов), специально подготовленный для обучения или тестирования нейросети. Это ее «учебник» и «экзаменационные билеты», на основе которых она познает мир.

- •Разметка / Аннотация (Annotation): Процесс добавления к «сырым» данным метаинформации (тегов, рамок, контуров), которая служит «правильными ответами» для модели в процессе обучения. По сути, это превращение непонятного для машины потока информации в структурированный урок.

- •Классификация, Детекция, Сегментация: Три основных типа разметки изображений. Классификация — это ответ на вопрос «что?» (кот или собака). Детекция — «где?» (обводка рамкой). Сегментация — это выделение точного контура объекта с точностью до пикселя для задач, требующих максимальной детализации.

- •Data Science и GPU: Data Science — это наука о данных, область знаний, которая позволяет извлекать из них ценность с помощью алгоритмов. GPU (графические процессоры) — это «железо», вычислительные мощности, которые идеально подходят для сложных расчетов при обучении нейросетей, выполняя роль «мышц» для «мозга» Data Science.

- •MVP (Minimum Viable Product): Минимально жизспособный продукт. Концепция, предполагающая создание первой, самой простой версии ИИ-системы для быстрой проверки гипотез на реальных данных с минимальными затратами, что позволяет избежать дорогостоящих ошибок на ранних этапах.

- •IoU (Intersection over Union): Ключевая метрика для оценки качества разметки в задачах детекции и сегментации. Она показывает, насколько точно рамка, нарисованная разметчиком, совпадает с эталонной, позволяя объективно измерять качество работы и избегать субъективизма.