Multimodal модели: текст, видео, аудио, изображения в одной модели

Multimodal модели: текст, видео, аудио, изображения в одной модели

АВТОР

Даниил Акерман

ДАТА ПУБЛИКАЦИИ

14 декабря 2025 г.

КАТЕГОРИЯ

ML

ВРЕМЯ ЧТЕНИЯ

10 минут

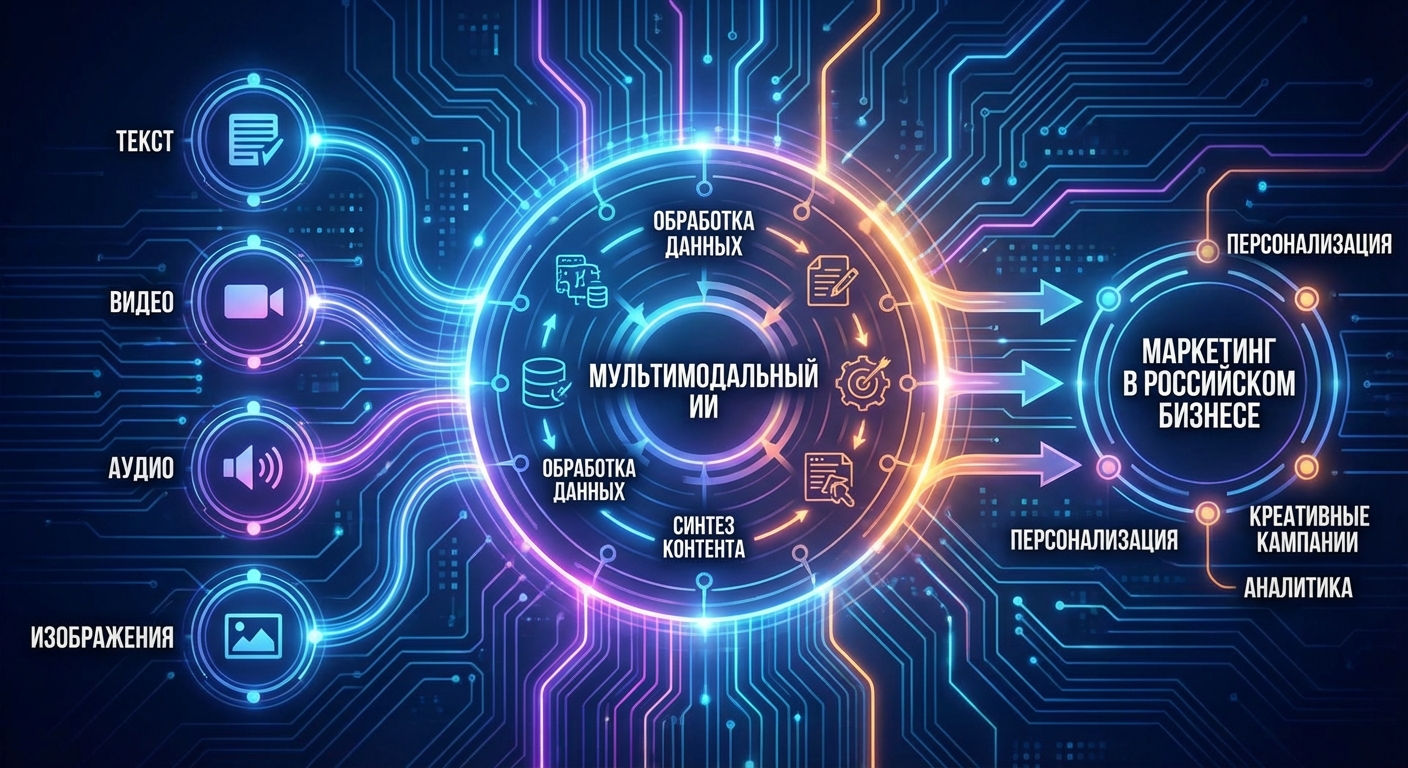

Традиционные языковые модели работали только с текстом. Но реальный мир мультимодален: мы воспринимаем информацию через текст, изображения, звуки, видео одновременно. Мультимодальные модели — это следующий шаг в эволюции AI, способные обрабатывать и генерировать данные разных типов в едином потоке. GPT-4o от OpenAI, Gemini 2.5 от Google, Claude 3.5 от Anthropic — все эти модели могут работать с текстом, изображениями, аудио и видео, открывая новые возможности для приложений.

Мультимодальность меняет правила игры. Вместо того чтобы использовать отдельные модели для каждого типа данных, одна модель может понимать контекст из разных источников одновременно. Это позволяет создавать более интеллектуальные приложения: ассистенты, которые видят экран и понимают контекст, системы анализа документов с изображениями и таблицами, генераторы контента, создающие текст и визуалы одновременно.

В 2025 году мультимодальные модели достигли уровня зрелости, когда они могут использоваться в production-приложениях. Качество обработки различных типов данных значительно улучшилось, а интеграция между модальностями стала более естественной. Как работают мультимодальные модели? Какие архитектурные подходы используются? Какие практические применения они открывают? В этой статье мы разберем принципы работы мультимодальных моделей, их архитектуру, сравнение различных подходов и практические рекомендации по использованию.

Принципы мультимодального AI

Мультимодальные модели должны решать несколько фундаментальных задач: представление данных разных типов в едином пространстве, понимание связей между модальностями, генерация данных разных типов на основе входов из различных модальностей. Понимание этих принципов помогает оценить возможности и ограничения мультимодальных моделей.

Первая задача — унификация представления. Текст, изображения, аудио и видео имеют совершенно разную природу: текст — это дискретная последовательность символов, изображения — это матрицы пикселей, аудио — это временные ряды амплитуд, видео — это последовательность изображений во времени. Мультимодальные модели должны преобразовать все эти типы данных в единое представление, которое может обрабатываться единой архитектурой.

Вторая задача — выравнивание модальностей (modality alignment). Модель должна понимать, что текст "красная машина" соответствует красной машине на изображении, что звук речи соответствует транскрипции текста, что видео показывает последовательность действий, описанных в тексте. Это требует обучения на парных данных, где представлены соответствия между разными модальностями.

Третья задача — кросс-модальное понимание. Модель должна уметь использовать информацию из одной модальности для понимания другой. Например, изображение может помочь понять контекст текста, или текст может помочь интерпретировать изображение. Это требует архитектуры, которая позволяет информации течь между модальностями.

Четвертая задача — генерация разных модальностей. Мультимодальная модель должна уметь генерировать данные разных типов на основе входов из различных модальностей. Например, генерировать описание изображения, создавать изображение по тексту, транскрибировать аудио в текст, генерировать видео по описанию.

Архитектурные подходы

Существует несколько основных архитектурных подходов к созданию мультимодальных моделей. Каждый подход имеет свои преимущества и ограничения, и выбор зависит от конкретных требований.

Первый подход — раннее слияние (early fusion). В этом подходе данные разных модальностей преобразуются в единое представление на раннем этапе, до обработки через основную архитектуру. Например, изображения могут быть преобразованы в последовательность токенов, аналогичную тексту, и обрабатываться вместе с текстовыми токенами. Преимущество этого подхода — простота и эффективность, недостаток — потеря специфических особенностей каждой модальности.

Второй подход — позднее слияние (late fusion). В этом подходе каждая модальность обрабатывается отдельно через специализированные энкодеры, а результаты объединяются на позднем этапе. Преимущество — сохранение специфических особенностей каждой модальности, недостаток — сложность интеграции и потенциальная потеря кросс-модальных связей.

Третий подход — кросс-модальное внимание (cross-modal attention). В этом подходе используются механизмы внимания для моделирования взаимодействий между модальностями. Каждая модальность имеет свои энкодеры, но механизм внимания позволяет им взаимодействовать на разных уровнях. Это наиболее гибкий подход, позволяющий моделировать сложные взаимодействия между модальностями.

Четвертый подход — унифицированные энкодеры (unified encoders). В этом подходе создаются энкодеры, способные обрабатывать данные разных типов. Например, Vision Transformer может обрабатывать изображения как последовательность патчей, аналогично тому, как языковая модель обрабатывает текст как последовательность токенов. Это позволяет использовать единую архитектуру для всех модальностей.

GPT-4o: omni-modal подход

GPT-4o от OpenAI представляет собой пример omni-modal модели, способной обрабатывать текст, изображения и аудио в едином потоке. "Omni" означает "все", отражая универсальность модели.

Архитектурно GPT-4o использует подход раннего слияния с оптимизациями. Изображения и аудио преобразуются в представления, которые могут обрабатываться вместе с текстом через единую трансформерную архитектуру. Модель обучалась на больших объемах мультимодальных данных, что позволило ей научиться понимать связи между различными модальностями.

Особенность GPT-4o — способность обрабатывать мультимодальные входы в реальном времени. Модель может анализировать изображения, аудио и текст одновременно, что делает ее особенно полезной для интерактивных приложений. Например, модель может видеть экран компьютера, слышать голос пользователя и понимать контекст разговора одновременно.

GPT-4o демонстрирует сильные результаты на задачах анализа изображений, транскрибации аудио, генерации текста на основе визуального контекста. Модель особенно эффективна в задачах, требующих понимания контекста из разных источников одновременно.

Gemini 2.5: нативная мультимодальность

Gemini 2.5 от Google был изначально спроектирован как мультимодальная модель с первого дня, что дает ему преимущества в интеграции различных модальностей.

Архитектурно Gemini 2.5 использует подход кросс-модального внимания с оптимизациями для эффективной обработки различных типов данных. Модель может обрабатывать текст, изображения, аудио и видео, причем обработка происходит более интегрированно, чем у моделей, которые были адаптированы для мультимодальности позже.

Особенность Gemini 2.5 — способность работать с видео напрямую, а не только через извлечение кадров. Модель может понимать временные зависимости в видео и анализировать динамические сцены. Это делает Gemini особенно сильным в задачах анализа видео и понимания действий.

Gemini 2.5 также интегрирован с экосистемой Google, что позволяет легко работать с документами Google Workspace, содержащими изображения, таблицы и другой мультимодальный контент. Это создает экосистемный эффект, где модель становится частью более широкого набора инструментов.

Claude 3.5: фокус на документах

Claude 3.5 от Anthropic фокусируется на работе с документами и текстом, но также поддерживает работу с изображениями. Подход Anthropic делает акцент на качестве понимания и точности, а не на поддержке всех возможных модальностей.

Архитектурно Claude 3.5 использует подход позднего слияния с кросс-модальным вниманием. Изображения обрабатываются через специализированный энкодер, а результаты интегрируются с текстовой обработкой через механизм внимания. Это позволяет модели сохранять сильные стороны в работе с текстом, добавляя возможности работы с изображениями.

Особенность Claude 3.5 — сильные результаты в анализе документов, содержащих изображения, диаграммы, таблицы. Модель может извлекать структурированную информацию из визуальных данных и интегрировать ее с текстовым анализом. Это делает Claude особенно полезным для задач работы с документами.

Claude 3.5 демонстрирует высокое качество в задачах анализа изображений документов, извлечения информации из форм и таблиц, понимания технических чертежей. Модель особенно эффективна, когда требуется точность и понимание контекста.

Практические применения

Мультимодальные модели открывают множество новых возможностей для приложений. Рассмотрим основные области применения.

Анализ документов с изображениями — одна из самых очевидных областей применения. Мультимодальные модели могут анализировать документы, содержащие текст, изображения, таблицы, диаграммы, извлекая информацию из всех источников одновременно. Это особенно полезно для автоматизации обработки документов, анализа отчетов, извлечения данных из форм.

Визуальные ассистенты — перспективное направление. Мультимодальные модели могут видеть экран компьютера, понимать контекст интерфейса и помогать пользователям выполнять задачи. Это открывает возможности для создания интеллектуальных помощников, которые могут работать с любыми приложениями через визуальный интерфейс.

Генерация контента — область, где мультимодальность особенно полезна. Модели могут генерировать текст и изображения одновременно, создавая согласованный контент. Например, модель может создать статью с соответствующими иллюстрациями или презентацию с текстом и визуалами.

Анализ видео и медиа — область, где мультимодальные модели могут анализировать видео, понимая как визуальный, так и аудиальный контент. Это полезно для задач автоматической модерации контента, анализа поведения, извлечения информации из видео.

Образовательные приложения могут использовать мультимодальные модели для создания интерактивного контента, который сочетает текст, изображения, аудио и видео. Модели могут адаптировать объяснения под предпочтения ученика и использовать различные модальности для лучшего понимания.

Технические вызовы

Работа с мультимодальными моделями создает ряд технических вызовов. Понимание этих вызовов помогает правильно планировать проекты и выбирать подходящие решения.

Первый вызов — размер данных. Изображения, аудио и видео занимают значительно больше места, чем текст. Это создает проблемы с хранением, передачей и обработкой данных. Требуются эффективные методы сжатия и оптимизации для работы с большими объемами мультимодальных данных.

Второй вызов — вычислительная сложность. Обработка мультимодальных данных требует значительных вычислительных ресурсов. Изображения и видео особенно требовательны к ресурсам, что может создавать проблемы с масштабированием и стоимостью.

Третий вызов — синхронизация модальностей. В задачах, где важна временная синхронизация (например, видео с аудио), модель должна правильно обрабатывать временные зависимости. Это требует специальных архитектурных решений и методов обучения.

Четвертый вызов — качество выравнивания. Качество мультимодальной модели сильно зависит от качества выравнивания между модальностями. Плохое выравнивание может привести к неправильному пониманию связей между данными разных типов.

Пятый вызов — оценка качества. Оценка качества мультимодальных моделей сложнее, чем оценка текстовых моделей. Требуются специальные метрики и методы оценки для различных типов задач и модальностей.

Оптимизация использования

Эффективное использование мультимодальных моделей требует внимания к нескольким аспектам. Рассмотрим основные рекомендации по оптимизации.

Выбирайте подходящую модель для задачи. Разные мультимодальные модели оптимизированы для разных задач: GPT-4o для интерактивных приложений, Gemini 2.5 для работы с видео, Claude 3.5 для анализа документов. Выбор правильной модели может значительно улучшить результаты.

Оптимизируйте входные данные. Качество входных данных критично для мультимодальных моделей. Убедитесь, что изображения имеют достаточное разрешение, аудио имеет хорошее качество, текст правильно отформатирован. Предобработка данных может значительно улучшить результаты.

Используйте промпты эффективно. Промпты для мультимодальных моделей должны четко указывать, как использовать информацию из разных модальностей. Указывайте, какие части изображения важны, как интерпретировать аудио, как интегрировать информацию из разных источников.

Учитывайте ограничения моделей. Мультимодальные модели могут иметь ограничения на размер изображений, длину аудио, количество модальностей в одном запросе. Понимание этих ограничений помогает правильно планировать использование моделей.

Мониторьте качество и стоимость. Мультимодальные модели могут быть дорогими в использовании из-за больших объемов данных и вычислительной сложности. Важно мониторить качество результатов и стоимость использования, оптимизируя баланс между ними.

Будущее мультимодальных моделей

Мультимодальные модели продолжают развиваться, и можно ожидать дальнейших улучшений. Рассмотрим перспективы развития.

Ожидается улучшение качества обработки различных модальностей. Разработка новых архитектур и методов обучения может улучшить качество понимания и генерации данных разных типов. Особенно перспективны направления улучшения работы с видео и аудио.

Вероятно появление более эффективных архитектур. Разработка архитектур, которые более эффективно обрабатывают мультимодальные данные, может снизить вычислительные требования и стоимость использования. Это откроет новые возможности для применения мультимодальных моделей.

Ожидается улучшение интеграции между модальностями. Разработка методов лучшего выравнивания и понимания связей между модальностями может улучшить качество мультимодальных моделей. Это особенно важно для задач, требующих глубокого понимания связей между данными разных типов.

Вероятно расширение поддерживаемых модальностей. Появление моделей, поддерживающих больше типов данных или новые модальности (например, 3D модели, тактильные данные), может открыть новые возможности для приложений.

Заключение

Мультимодальные модели представляют собой важный шаг в развитии искусственного интеллекта, открывая возможности для создания более интеллектуальных и естественных приложений. Способность обрабатывать и генерировать данные разных типов в едином потоке делает мультимодальные модели особенно полезными для задач, требующих понимания контекста из различных источников.

Выбор между различными мультимодальными моделями зависит от конкретных требований проекта. GPT-4o оптимальна для интерактивных приложений, Gemini 2.5 — для работы с видео, Claude 3.5 — для анализа документов. Понимание особенностей каждой модели помогает выбрать подходящее решение.

Для разработчиков важно понимать принципы работы мультимодальных моделей, их возможности и ограничения. Правильное использование мультимодальных моделей может значительно улучшить качество приложений и открыть новые возможности для создания интеллектуальных систем.

Словарь терминов

Мультимодальная модель (Multimodal Model) — модель искусственного интеллекта, способная обрабатывать и генерировать данные разных типов: текст, изображения, аудио, видео.

Модальность (Modality) — тип данных или способ представления информации, например, текст, изображение, аудио, видео.

Выравнивание модальностей (Modality Alignment) — процесс обучения модели понимать соответствия между данными разных типов, например, между текстом и изображением.

Кросс-модальное внимание (Cross-modal Attention) — механизм внимания, позволяющий модели взаимодействовать с данными разных модальностей для понимания связей между ними.

Раннее слияние (Early Fusion) — подход к мультимодальности, при котором данные разных типов объединяются на раннем этапе обработки.

Позднее слияние (Late Fusion) — подход к мультимодальности, при котором данные разных типов обрабатываются отдельно и объединяются на позднем этапе.

Omni-modal — термин, описывающий модели, способные обрабатывать все типы данных в едином потоке.

Энкодер (Encoder) — компонент модели, преобразующий входные данные в представление, пригодное для обработки.

Транскрибация (Transcription) — процесс преобразования аудио в текст.

Временные зависимости (Temporal Dependencies) — связи между данными в разные моменты времени, важные для обработки видео и аудио.

Похожие статьи

Все статьи

Телеграмм

Делимся визуально привлекательными фрагментами наших последних веб-проектов.

ВКонтакте

Пишем о интересных технических решениях и вызовах в разработке.

MAX

Демонстрируем дизайнерские элементы наших веб-проектов.

Создаем детальные презентации для наших проектов.

Рассылка

Подпишитесь на нашу рассылку

© 2025 MYPL. Все права защищены.