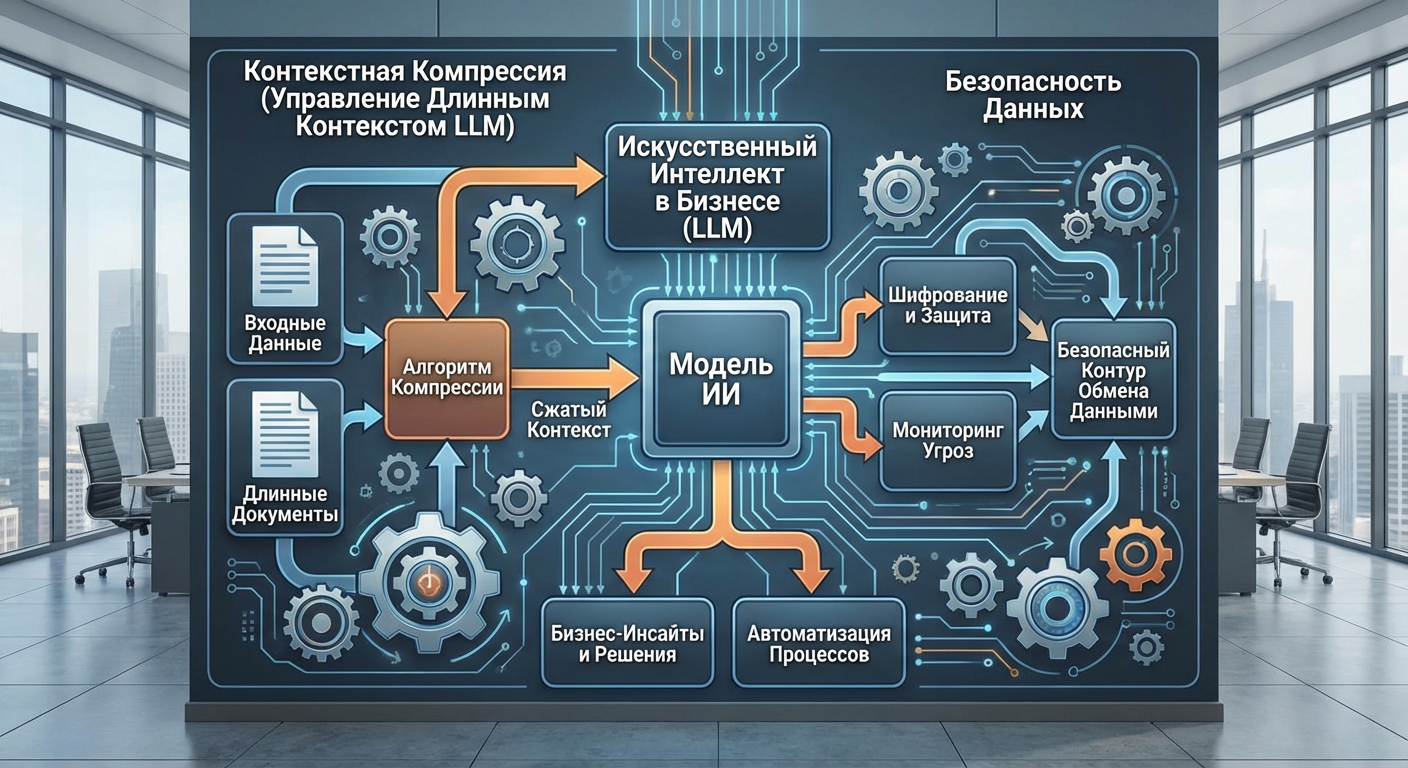

Контекстная компрессия и управление длинным контекстом в LLM

Современные языковые модели могут обрабатывать все более длинные контексты — от нескольких тысяч токенов до миллионов. Однако просто передать модели огромный объем текста недостаточно: нужно уметь эффективно управлять этим контекстом, извлекать релевантную информацию и компрессировать данные без потери важных деталей. Контекстная компрессия и управление длинным контекстом стали критически важными навыками для работы с LLM в production-системах.

Проблема длинного контекста не только в технических ограничениях моделей, но и в качестве обработки. Даже если модель технически может принять миллион токенов, она может "потеряться" в этом объеме информации, не сумев выделить ключевые моменты. Более того, стоимость обработки растет пропорционально длине контекста, что делает неэффективным простое увеличение объема входных данных. Контекстная компрессия решает эти проблемы, позволяя сохранять важную информацию при значительном сокращении объема.

В 2025 году управление контекстом стало отдельной дисциплиной в работе с LLM. От RAG-систем до долгоживущих агентов — везде требуется умение эффективно работать с большими объемами информации. Какие техники компрессии существуют? Как выбрать подходящий метод? Как реализовать управление контекстом на практике? В этой статье мы разберем основные подходы к контекстной компрессии, техники управления длинным контекстом и практические рекомендации по применению.

Проблемы длинного контекста

Понимание проблем, которые возникают при работе с длинным контекстом, помогает выбрать правильные техники компрессии. Каждая проблема требует своего подхода.

Первая проблема — ограничения внимания модели. Даже при технической возможности обработать длинный контекст, модель может не справиться с выделением релевантной информации из большого объема данных. Механизм внимания (attention mechanism) имеет ограничения в том, насколько эффективно он может обрабатывать информацию на больших расстояниях. Информация в начале контекста может быть "забыта" к моменту генерации ответа, если она находится слишком далеко.

Вторая проблема — стоимость вычислений. Обработка длинного контекста требует значительных вычислительных ресурсов. Стоимость API-запросов к LLM обычно рассчитывается на основе количества токенов во входных данных и выходных данных. Увеличение контекста в два раза увеличивает стоимость примерно в два раза. Для систем с большим объемом запросов это может стать критическим фактором.

Третья проблема — задержка обработки. Длинный контекст требует больше времени на обработку, что увеличивает задержку ответа системы. Для интерактивных приложений это может быть критично. Пользователи ожидают быстрых ответов, и увеличение задержки может негативно сказаться на пользовательском опыте.

Четвертая проблема — качество генерации. Слишком длинный контекст может содержать противоречивую или избыточную информацию, что может ухудшить качество ответа модели. Модель может "запутаться" в большом объеме данных и сгенерировать менее точный ответ, чем при работе с более компактным контекстом.

Пятая проблема — управление памятью. В долгоживущих системах, таких как чат-боты или агенты, контекст может расти неограниченно. Без управления памятью система может столкнуться с техническими ограничениями или стать неэффективной. Необходимы механизмы для поддержания контекста в разумных пределах при сохранении важной информации.

Основные техники компрессии

Существует несколько основных техник компрессии контекста, каждая со своими преимуществами и ограничениями. Выбор техники зависит от конкретной задачи и требований к качеству.

Резюмирование (Summarization)

Резюмирование — одна из самых простых и распространенных техник компрессии. Идея заключается в том, чтобы создать краткое изложение длинного текста, сохранив ключевые моменты. Резюмирование может быть выполнено самой LLM или специализированными моделями для суммаризации.

Резюмирование хорошо работает для текстов, где важна общая информация, а не конкретные детали. Например, для новостных статей или отчетов резюмирование может эффективно сократить объем при сохранении основных фактов. Однако для задач, где важны точные детали или цитаты, резюмирование может быть недостаточным.

Существует несколько подходов к резюмированию. Extractive summarization извлекает ключевые предложения из исходного текста без изменения. Abstractive summarization создает новое краткое изложение, которое может содержать информацию, не присутствующую дословно в исходном тексте. Выбор подхода зависит от требований к точности и стилю резюме.

Извлечение релевантных фрагментов (Relevance Extraction)

Извлечение релевантных фрагментов — техника, при которой из длинного контекста извлекаются только те части, которые релевантны текущему запросу. Это особенно эффективно в RAG-системах, где нужно найти информацию, относящуюся к конкретному вопросу.

Процесс обычно включает два этапа: поиск релевантных фрагментов и ранжирование их по релевантности. Поиск может выполняться с помощью векторного поиска в embeddings или с помощью keyword-based поиска. Ранжирование помогает выбрать наиболее релевантные фрагменты из найденных.

Извлечение релевантных фрагментов эффективно, когда запрос конкретен и можно четко определить, какая информация нужна. Однако для задач, где важна общая картина или контекст, этот подход может быть недостаточным, так как изолированные фрагменты могут потерять важные связи.

Иерархическая компрессия (Hierarchical Compression)

Иерархическая компрессия — техника, при которой контекст структурируется в иерархию и компрессируется на разных уровнях. Например, документ может быть разбит на разделы, разделы на параграфы, параграфы на предложения. Компрессия применяется на каждом уровне, создавая многоуровневое представление информации.

Иерархическая компрессия позволяет сохранить структуру информации и обеспечить доступ к информации на разных уровнях детализации. Это особенно полезно для длинных документов со сложной структурой, таких как техническая документация или научные статьи.

При запросе система может сначала обратиться к высокоуровневому резюме, а затем при необходимости углубиться в более детальные уровни. Это позволяет эффективно управлять объемом контекста, передавая модели только необходимый уровень детализации.

Sliding Window

Sliding Window — техника, при которой контекст разбивается на перекрывающиеся окна фиксированного размера, и обработка происходит по окнам. Это позволяет обрабатывать контекст любой длины, работая с окнами, которые помещаются в ограничения модели.

Sliding Window особенно эффективен для задач, где важна локальная информация, а не глобальный контекст. Например, для анализа текста по частям или для обработки потоковых данных. Однако для задач, требующих понимания всего контекста целиком, этот подход может быть ограничен.

Важным аспектом Sliding Window является размер перекрытия между окнами. Перекрытие помогает сохранить контекст на границах окон и избежать потери информации. Однако слишком большое перекрытие увеличивает объем обрабатываемых данных, что может быть неэффективно.

Управление контекстом в долгоживущих системах

Долгоживущие системы, такие как чат-боты или агенты, сталкиваются с уникальными проблемами управления контекстом. Контекст может расти неограниченно в течение сессии, и необходимы механизмы для его управления.

Управление памятью диалога

Управление памятью диалога — ключевой аспект долгоживущих систем. Простое накопление всех сообщений в контексте быстро приводит к превышению лимитов модели. Необходимы стратегии для поддержания контекста в разумных пределах.

Один из подходов — резюмирование истории диалога. Периодически система может создавать резюме предыдущих сообщений и заменять детальную историю на резюме. Это позволяет сохранить важную информацию, значительно сократив объем контекста.

Другой подход — избирательное сохранение сообщений. Система может сохранять только важные сообщения, такие как ключевые решения, важные факты или изменения контекста. Менее важные сообщения могут быть удалены или резюмированы.

Иерархия памяти

Иерархия памяти — концепция организации памяти на разных уровнях важности и доступности. Краткосрочная память содержит недавние сообщения и события, которые могут быть важны для текущего контекста. Долгосрочная память содержит важную информацию, которая должна сохраняться на протяжении всей сессии.

При работе с запросом система может обращаться к краткосрочной памяти для недавнего контекста и к долгосрочной памяти для важной информации. Это позволяет эффективно управлять объемом контекста, сохраняя при этом необходимую информацию.

Компрессия на лету

Компрессия на лету — техника, при которой контекст компрессируется в реальном времени по мере его роста. Когда контекст достигает определенного размера, система автоматически применяет компрессию, чтобы освободить место для новых данных.

Компрессия на лету требует баланса между качеством компрессии и скоростью обработки. Слишком агрессивная компрессия может привести к потере важной информации, а слишком медленная компрессия может не успеть освободить место до превышения лимитов.

Практические рекомендации

Выбор и применение техник компрессии требует понимания конкретной задачи и требований. Рассмотрим практические рекомендации для различных сценариев.

Выбор техники компрессии

Выбор техники компрессии зависит от типа задачи и требований к качеству. Для задач, где важна общая информация, резюмирование может быть эффективным выбором. Для задач с конкретными запросами извлечение релевантных фрагментов может быть более подходящим.

Для длинных документов со сложной структурой иерархическая компрессия может обеспечить лучший баланс между компрессией и сохранением информации. Для потоковых данных или задач с локальной важностью Sliding Window может быть оптимальным выбором.

Важно учитывать требования к точности. Если важны точные детали или цитаты, техники, которые создают новые формулировки (такие как abstractive summarization), могут быть менее подходящими, чем техники извлечения.

Оценка качества компрессии

Оценка качества компрессии — важный аспект применения техник компрессии. Качество можно оценивать по различным метрикам: сохранение ключевой информации, точность ответов на вопросы, сохранение структуры и связей.

Для оценки можно использовать тестовые запросы и сравнивать ответы модели на полном и компрессированном контексте. Если качество ответов существенно не ухудшается, компрессия считается успешной.

Важно также учитывать специфику задачи. Для некоторых задач небольшая потеря информации может быть приемлемой, если она компенсируется снижением стоимости и задержки. Для других задач точность критична, и компрессия должна быть более консервативной.

Оптимизация производительности

Оптимизация производительности включает балансирование между качеством компрессии и вычислительными затратами. Более агрессивная компрессия может снизить стоимость и задержку, но может ухудшить качество. Менее агрессивная компрессия может сохранить качество, но увеличить затраты.

Важно измерять производительность в контексте конкретной задачи. Метрики, такие как стоимость на запрос, задержка ответа и качество ответов, должны отслеживаться и использоваться для оптимизации.

Кэширование компрессированных версий контекста может помочь снизить вычислительные затраты, если один и тот же контекст используется многократно. Однако кэширование требует управления и может быть неэффективным для динамически изменяющегося контекста.

Интеграция с RAG-системами

Контекстная компрессия особенно важна в RAG-системах, где нужно эффективно работать с большими объемами документов. Рассмотрим специфику применения компрессии в RAG.

В RAG-системах компрессия может применяться на разных этапах. На этапе индексации документы могут быть разбиты на чанки и сжаты для более эффективного хранения и поиска. На этапе извлечения релевантные чанки могут быть дополнительно компрессированы перед передачей в модель.

Важным аспектом является баланс между размером чанков и качеством поиска. Слишком маленькие чанки могут потерять контекст, а слишком большие могут содержать нерелевантную информацию. Компрессия может помочь оптимизировать этот баланс.

Ранжирование (reranking) релевантных чанков может быть объединено с компрессией. Более релевантные чанки могут быть переданы с меньшей компрессией, а менее релевантные — с большей компрессией или вообще исключены из контекста.

Заключение

Контекстная компрессия и управление длинным контекстом — критически важные навыки для работы с LLM в production-системах. Правильный выбор и применение техник компрессии позволяет эффективно работать с большими объемами информации, снижая стоимость и задержку при сохранении качества ответов.

Выбор техники компрессии зависит от конкретной задачи и требований. Резюмирование подходит для задач с общей информацией, извлечение релевантных фрагментов — для конкретных запросов, иерархическая компрессия — для структурированных документов, Sliding Window — для потоковых данных.

В долгоживущих системах управление памятью требует специальных подходов, таких как резюмирование истории, избирательное сохранение и иерархия памяти. Компрессия на лету позволяет эффективно управлять растущим контекстом.

Оценка качества компрессии и оптимизация производительности важны для успешного применения техник компрессии. Измерение метрик и балансирование между качеством и затратами позволяет найти оптимальное решение для конкретной задачи.

Словарь терминов

Контекстная компрессия — техника сокращения объема контекста при сохранении важной информации для эффективной работы с длинными текстами в LLM.

Механизм внимания (Attention Mechanism) — компонент нейронной сети, который определяет, на какие части входных данных обращать внимание при генерации ответа.

Резюмирование (Summarization) — техника создания краткого изложения длинного текста, сохраняющего ключевые моменты.

Extractive Summarization — подход к резюмированию, при котором из исходного текста извлекаются ключевые предложения без изменения.

Abstractive Summarization — подход к резюмированию, при котором создается новое краткое изложение, которое может содержать информацию, не присутствующую дословно в исходном тексте.

Извлечение релевантных фрагментов (Relevance Extraction) — техника извлечения из длинного контекста только тех частей, которые релевантны текущему запросу.

Иерархическая компрессия (Hierarchical Compression) — техника структурирования контекста в иерархию и компрессии на разных уровнях для сохранения структуры информации.

Sliding Window — техника разбиения контекста на перекрывающиеся окна фиксированного размера для обработки контекста любой длины.

Управление памятью диалога — стратегии поддержания контекста диалога в разумных пределах в долгоживущих системах.

Иерархия памяти — концепция организации памяти на разных уровнях важности и доступности (краткосрочная и долгосрочная память).

Компрессия на лету — техника компрессии контекста в реальном времени по мере его роста для освобождения места для новых данных.

RAG (Retrieval-Augmented Generation) — архитектура систем, которая комбинирует поиск информации из базы знаний с генерацией ответов языковой моделью.

Ранжирование (Reranking) — процесс переупорядочивания результатов поиска по релевантности для улучшения качества извлечения информации.

Чанки (Chunks) — фрагменты текста, на которые разбиваются документы для более эффективного хранения и поиска в RAG-системах.

Токены — единицы текста, на которые разбивается входной текст для обработки языковой моделью.